九游平台/

ai开发平台modelarts/

modelarts用户指南(standard)/

制作自定义镜像用于modelarts standard/

制作自定义镜像用于训练模型/

训练作业的自定义镜像制作流程

更新时间:2025-03-04 gmt 08:00

训练作业的自定义镜像制作流程-九游平台

如果您已经在本地完成模型开发或训练脚本的开发,且您使用的ai引擎是modelarts不支持的框架。您可以制作自定义镜像,并上传至swr服务。您可以在modelarts使用此自定义镜像创建训练作业,使用modelarts提供的资源训练模型。

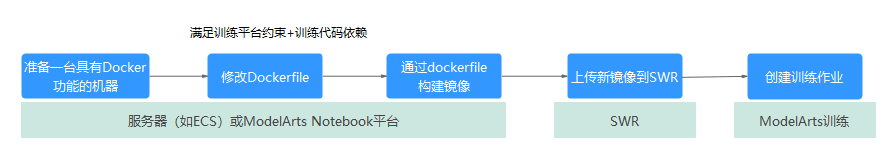

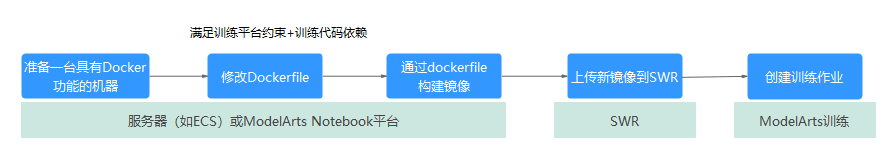

制作流程

图1 训练作业的自定义镜像制作流程

场景一:预置镜像满足modelarts训练平台约束,但不满足代码依赖的要求,需要额外安装软件包。

具体案例参考使用预置镜像制作自定义镜像用于训练模型。

场景二:已有本地镜像满足代码依赖的要求,但是不满足modelarts训练平台约束,需要适配。

具体案例参考已有镜像迁移至modelarts用于训练模型。

场景三: 当前无可使用的镜像,需要从0制作镜像(既需要安装代码依赖,又需要制作出的镜像满足mamodelarts平台约束)。具体案例参考:

从0制作自定义镜像用于创建训练作业(pytorch cpu/gpu)

从0制作自定义镜像用于创建训练作业(mpi cpu/gpu)

训练框架的自定义镜像约束

- 推荐自定义镜像使用ubuntu-18.04的操作系统,避免出现版本不兼容的问题。

- 自定义镜像的大小推荐15gb以内,最大不要超过资源池的容器引擎空间大小的一半。镜像过大会直接影响训练作业的启动时间。

modelarts公共资源池的容器引擎空间为50g,专属资源池的容器引擎空间的默认为50g,支持在创建专属资源池时自定义容器引擎空间。

- 自定义镜像的默认用户必须为“uid”为“1000”的用户。

- 自定义镜像中不能安装gpu或ascend驱动程序。当用户选择gpu资源运行训练作业时,modelarts后台自动将gpu驱动程序放置在训练环境中的 /usr/local/nvidia目录;当用户选择ascend资源运行训练作业时,modelarts后台自动将ascend驱动程序放置在/usr/local/ascend/driver目录。

- x86 cpu架构和arm cpu架构的自定义镜像分别只能运行于对应cpu架构的规格中。

执行如下命令,查看自定义镜像的cpu架构。

docker inspect {自定义镜像地址} | grep architecturearm cpu架构的自定义镜像,上述命令回显如下。"architecture": "arm64"

- 规格中带有arm字样的显示,为arm cpu架构。

- 规格中未带有arm字样的显示,为x86 cpu架构。

- modelarts后台暂不支持下载开源安装包,建议用户在自定义镜像中安装训练所需的依赖包。

- 自定义镜像需上传至容器镜像服务(swr)才能在modelarts上用于训练。

父主题: 制作自定义镜像用于训练模型

相关文档

意见反馈

文档内容是否对您有帮助?

提交成功!非常感谢您的反馈,我们会继续努力做到更好!

您可在查看反馈及问题处理状态。

系统繁忙,请稍后重试

如您有其它疑问,您也可以通过华为云社区问答频道来与我们联系探讨